So installieren Sie Hadoop mit Schritt-für-Schritt-Konfiguration unter Linux Ubuntu

In diesem Tutorial führen wir Sie Schritt für Schritt durch die Installation von Apache Hadoop auf einer Linux-Box (Ubuntu). Dies ist ein zweiteiliger Prozess

Es gibt 2 Voraussetzungen:

- Sie müssen Ubuntu installiert laufen

- Sie müssen Java Installiert.

Teil 1) Hadoop herunterladen und installieren

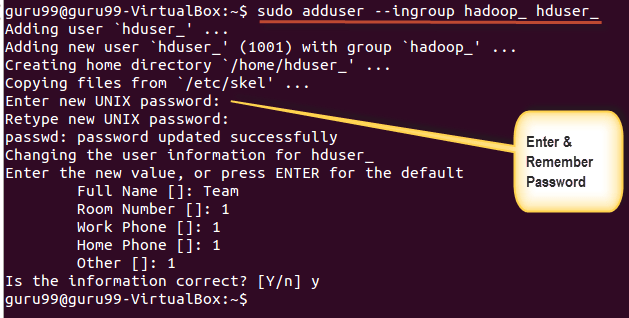

Schritt 1) Fügen Sie mit dem folgenden Befehl einen Hadoop-Systembenutzer hinzu

sudo addgroup hadoop_

sudo adduser --ingroup hadoop_ hduser_

Geben Sie Ihr Passwort, Ihren Namen und weitere Details ein.

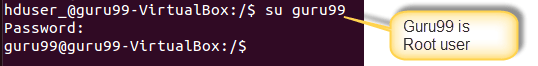

Anmerkungen: Bei diesem Einrichtungs- und Installationsprozess besteht die Möglichkeit des unten aufgeführten Fehlers.

„hduser ist nicht in der sudoers-Datei. Dieser Vorfall wird gemeldet.“

Dieser Fehler kann durch die Anmeldung als Root-Benutzer behoben werden

Führen Sie den Befehl aus

sudo adduser hduser_ sudo

Re-login as hduser_

Schritt 2) Konfigurieren Sie SSH

Um Knoten in einem Cluster verwalten zu können, benötigt Hadoop SSH-Zugriff

Wechseln Sie zunächst den Benutzer und geben Sie den folgenden Befehl ein

su - hduser_

Dieser Befehl erstellt einen neuen Schlüssel.

ssh-keygen -t rsa -P ""

Aktivieren Sie mit diesem Schlüssel den SSH-Zugriff auf den lokalen Computer.

cat $HOME/.ssh/id_rsa.pub >> $HOME/.ssh/authorized_keys

Testen Sie nun die SSH-Einrichtung, indem Sie als Benutzer „hduser“ eine Verbindung zu localhost herstellen.

ssh localhost

Hinweis: Bitte beachten Sie: Wenn Sie als Antwort auf „ssh localhost“ die folgende Fehlermeldung sehen, besteht die Möglichkeit, dass SSH auf diesem System nicht verfügbar ist.

Um dieses Problem zu lösen –

Bereinigen Sie SSH mit:

sudo apt-get purge openssh-server

Es empfiehlt sich, vor Beginn der Installation eine Spülung durchzuführen

Installieren Sie SSH mit dem Befehl-

sudo apt-get install openssh-server

Schritt 3) Der nächste Schritt besteht darin Laden Sie Hadoop herunter

Wählen Sie Stabil aus

Wählen Sie die Datei tar.gz aus (nicht die Datei mit src)

Navigieren Sie nach Abschluss des Downloads zu dem Verzeichnis, das die TAR-Datei enthält

Geben Sie,

sudo tar xzf hadoop-2.2.0.tar.gz

Benennen Sie nun hadoop-2.2.0 in hadoop um

sudo mv hadoop-2.2.0 hadoop

sudo chown -R hduser_:hadoop_ hadoop

Teil 2) Hadoop konfigurieren

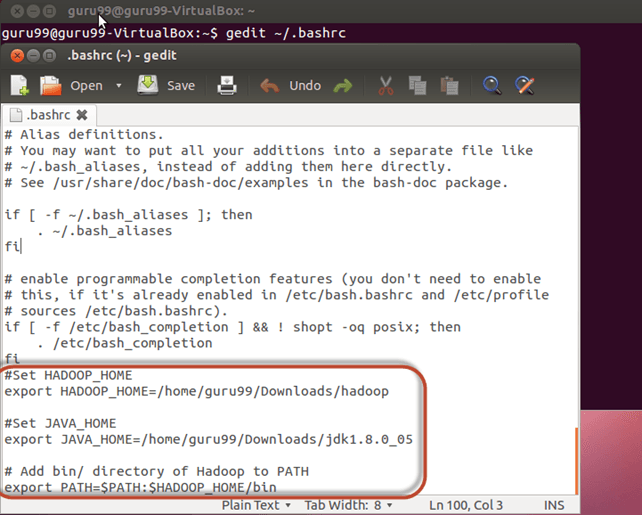

Schritt 1) Ändern ~ / .bashrc Datei

Fügen Sie am Ende der Datei die folgenden Zeilen hinzu ~ / .bashrc

#Set HADOOP_HOME export HADOOP_HOME=<Installation Directory of Hadoop> #Set JAVA_HOME export JAVA_HOME=<Installation Directory of Java> # Add bin/ directory of Hadoop to PATH export PATH=$PATH:$HADOOP_HOME/bin

Geben Sie nun diese Umgebungskonfiguration mit dem folgenden Befehl als Quelle an

. ~/.bashrc

Schritt 2) Konfigurationen im Zusammenhang mit HDFS

Stelle den JAVA_HOME in der Datei $HADOOP_HOME/etc/hadoop/hadoop-env.sh

Mit

Es gibt zwei Parameter $HADOOP_HOME/etc/hadoop/core-site.xml die eingestellt werden müssen-

1. 'hadoop.tmp.dir' – Wird verwendet, um ein Verzeichnis anzugeben, das von Hadoop zum Speichern seiner Datendateien verwendet wird.

2. 'fs.default.name' – Dies gibt das Standarddateisystem an.

Um diese Parameter festzulegen, öffnen Sie core-site.xml

sudo gedit $HADOOP_HOME/etc/hadoop/core-site.xml

Kopieren Sie die folgende Zeile zwischen den Tags

<property> <name>hadoop.tmp.dir</name> <value>/app/hadoop/tmp</value> <description>Parent directory for other temporary directories.</description> </property> <property> <name>fs.defaultFS </name> <value>hdfs://localhost:54310</value> <description>The name of the default file system. </description> </property>

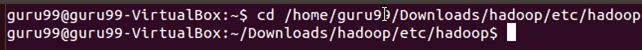

Navigieren Sie zum Verzeichnis $HADOOP_HOME/etc/Hadoop

Erstellen Sie nun das in core-site.xml erwähnte Verzeichnis

sudo mkdir -p <Path of Directory used in above setting>

Erteilen Sie Berechtigungen für das Verzeichnis

sudo chown -R hduser_:Hadoop_ <Path of Directory created in above step>

sudo chmod 750 <Path of Directory created in above step>

Schritt 3) Konfiguration der Kartenreduzierung

Bevor Sie mit diesen Konfigurationen beginnen, legen wir den HADOOP_HOME-Pfad fest

sudo gedit /etc/profile.d/hadoop.sh

Und treten Sie ein

export HADOOP_HOME=/home/guru99/Downloads/Hadoop

Als nächstes eingeben

sudo chmod +x /etc/profile.d/hadoop.sh

Verlassen Sie das Terminal und starten Sie es erneut

Geben Sie echo $HADOOP_HOME ein. Um den Pfad zu überprüfen

Kopieren Sie nun die Dateien

sudo cp $HADOOP_HOME/etc/hadoop/mapred-site.xml.template $HADOOP_HOME/etc/hadoop/mapred-site.xml

Öffnen Sie den Microsoft Store auf Ihrem Windows-PC mapred-site.xml Datei

sudo gedit $HADOOP_HOME/etc/hadoop/mapred-site.xml

Fügen Sie die folgenden Einstellungszeilen zwischen den Tags hinzu Und

<property> <name>mapreduce.jobtracker.address</name> <value>localhost:54311</value> <description>MapReduce job tracker runs at this host and port. </description> </property>

Öffne $HADOOP_HOME/etc/hadoop/hdfs-site.xml wie nachstehend,

sudo gedit $HADOOP_HOME/etc/hadoop/hdfs-site.xml

Fügen Sie die folgenden Einstellungszeilen zwischen den Tags hinzu Und

<property> <name>dfs.replication</name> <value>1</value> <description>Default block replication.</description> </property> <property> <name>dfs.datanode.data.dir</name> <value>/home/hduser_/hdfs</value> </property>

Erstellen Sie ein in der obigen Einstellung angegebenes Verzeichnis.

sudo mkdir -p <Path of Directory used in above setting>

sudo mkdir -p /home/hduser_/hdfs

sudo chown -R hduser_:hadoop_ <Path of Directory created in above step>

sudo chown -R hduser_:hadoop_ /home/hduser_/hdfs

sudo chmod 750 <Path of Directory created in above step>

sudo chmod 750 /home/hduser_/hdfs

Schritt 4) Bevor wir Hadoop zum ersten Mal starten, formatieren Sie HDFS mit dem folgenden Befehl

$HADOOP_HOME/bin/hdfs namenode -format

Schritt 5) Starten Sie den Hadoop-Einzelknotencluster mit dem folgenden Befehl

$HADOOP_HOME/sbin/start-dfs.sh

Eine Ausgabe des obigen Befehls

$HADOOP_HOME/sbin/start-yarn.sh

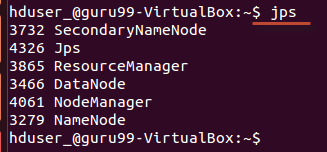

Die Verwendung von 'jps' Überprüfen Sie mit dem Tool/Befehl, ob alle Hadoop-bezogenen Prozesse ausgeführt werden oder nicht.

Wenn Hadoop erfolgreich gestartet wurde, sollte eine Ausgabe von jps NameNode, NodeManager, ResourceManager, SecondaryNameNode, DataNode anzeigen.

Schritt 6) Hadoop stoppen

$HADOOP_HOME/sbin/stop-dfs.sh

$HADOOP_HOME/sbin/stop-yarn.sh