Jak nainstalovat Hadoop s konfigurací krok za krokem v systému Linux Ubuntu

V tomto tutoriálu vás krok za krokem provedeme procesem instalace Apache Hadoop na linuxový box (Ubuntu). Toto je 2-dílný proces

Existují 2 Předpoklady

- Musíte mít Ubuntu instalovány a běží

- Musíte mít Java Instalováno.

Část 1) Stáhněte a nainstalujte Hadoop

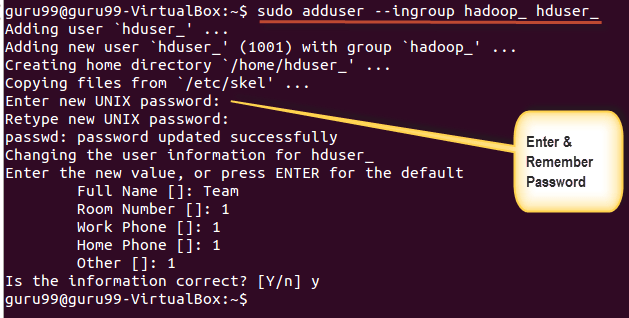

Krok 1) Pomocí níže uvedeného příkazu přidejte uživatele systému Hadoop

sudo addgroup hadoop_

sudo adduser --ingroup hadoop_ hduser_

Zadejte své heslo, jméno a další podrobnosti.

POZNÁMKA: V tomto procesu nastavení a instalace může dojít k níže uvedené chybě.

„hduser není v souboru sudoers. Tento incident bude nahlášen."

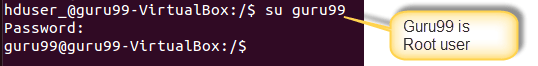

Tuto chybu lze vyřešit přihlášením jako uživatel root

Proveďte příkaz

sudo adduser hduser_ sudo

Re-login as hduser_

Krok 2) Nakonfigurujte SSH

Aby bylo možné spravovat uzly v clusteru, vyžaduje Hadoop přístup SSH

Nejprve přepněte uživatele a zadejte následující příkaz

su - hduser_

Tento příkaz vytvoří nový klíč.

ssh-keygen -t rsa -P ""

Povolte přístup SSH k místnímu počítači pomocí tohoto klíče.

cat $HOME/.ssh/id_rsa.pub >> $HOME/.ssh/authorized_keys

Nyní otestujte nastavení SSH připojením k localhost jako uživatel 'hduser'.

ssh localhost

Poznámka: Vezměte prosím na vědomí, že pokud vidíte níže chybu v reakci na 'ssh localhost', pak je možné, že SSH není v tomto systému k dispozici-

Chcete-li to vyřešit -

Vyčistit SSH pomocí,

sudo apt-get purge openssh-server

Je dobrým zvykem před zahájením instalace vyčistit

Nainstalujte SSH pomocí příkazu-

sudo apt-get install openssh-server

Krok 3) Dalším krokem je Stáhněte si Hadoop

Vyberte možnost Stabilní

Vyberte soubor tar.gz (ne soubor s src)

Po dokončení stahování přejděte do adresáře obsahujícího soubor tar

Enter,

sudo tar xzf hadoop-2.2.0.tar.gz

Nyní přejmenujte hadoop-2.2.0 na hadoop

sudo mv hadoop-2.2.0 hadoop

sudo chown -R hduser_:hadoop_ hadoop

Část 2) Nakonfigurujte Hadoop

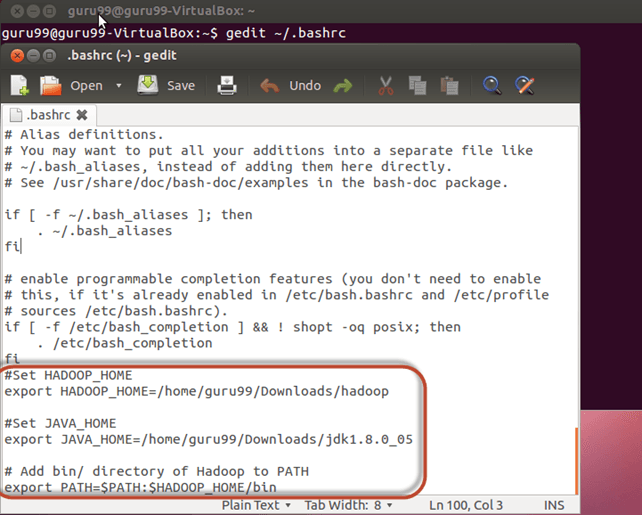

Krok 1) Upravit ~ / .bashrc soubor

Přidejte následující řádky na konec souboru ~ / .bashrc

#Set HADOOP_HOME export HADOOP_HOME=<Installation Directory of Hadoop> #Set JAVA_HOME export JAVA_HOME=<Installation Directory of Java> # Add bin/ directory of Hadoop to PATH export PATH=$PATH:$HADOOP_HOME/bin

Nyní vytvořte zdroj této konfigurace prostředí pomocí níže uvedeného příkazu

. ~/.bashrc

Krok 2) Konfigurace související s HDFS

sada JAVA_HOME uvnitř souboru $HADOOP_HOME/etc/hadoop/hadoop-env.sh

S

Jsou tam dva parametry $HADOOP_HOME/etc/hadoop/core-site.xml které je třeba nastavit -

1. 'hadoop.tmp.dir' – Používá se k určení adresáře, který bude Hadoop používat k ukládání svých datových souborů.

2. 'fs.default.name' – Toto určuje výchozí systém souborů.

Chcete-li nastavit tyto parametry, otevřete soubor core-site.xml

sudo gedit $HADOOP_HOME/etc/hadoop/core-site.xml

Zkopírujte pod řádek mezi značky

<property> <name>hadoop.tmp.dir</name> <value>/app/hadoop/tmp</value> <description>Parent directory for other temporary directories.</description> </property> <property> <name>fs.defaultFS </name> <value>hdfs://localhost:54310</value> <description>The name of the default file system. </description> </property>

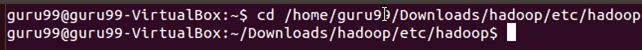

Přejděte do adresáře $HADOOP_HOME/etc/Hadoop

Nyní vytvořte adresář uvedený v core-site.xml

sudo mkdir -p <Path of Directory used in above setting>

Udělte oprávnění k adresáři

sudo chown -R hduser_:Hadoop_ <Path of Directory created in above step>

sudo chmod 750 <Path of Directory created in above step>

Krok 3) Konfigurace zmenšení mapy

Než začnete s těmito konfiguracemi, nastavte cestu HADOOP_HOME

sudo gedit /etc/profile.d/hadoop.sh

A Enter

export HADOOP_HOME=/home/guru99/Downloads/Hadoop

Další vstup

sudo chmod +x /etc/profile.d/hadoop.sh

Ukončete terminál a znovu jej restartujte

Zadejte echo $HADOOP_HOME. Pro ověření cesty

Nyní zkopírujte soubory

sudo cp $HADOOP_HOME/etc/hadoop/mapred-site.xml.template $HADOOP_HOME/etc/hadoop/mapred-site.xml

Otevřete maped-site.xml soubor

sudo gedit $HADOOP_HOME/etc/hadoop/mapred-site.xml

Přidejte níže uvedené řádky nastavení mezi značky a

<property> <name>mapreduce.jobtracker.address</name> <value>localhost:54311</value> <description>MapReduce job tracker runs at this host and port. </description> </property>

Otevřená $HADOOP_HOME/etc/hadoop/hdfs-site.xml jak je uvedeno níže,

sudo gedit $HADOOP_HOME/etc/hadoop/hdfs-site.xml

Přidejte níže uvedené řádky nastavení mezi značky a

<property> <name>dfs.replication</name> <value>1</value> <description>Default block replication.</description> </property> <property> <name>dfs.datanode.data.dir</name> <value>/home/hduser_/hdfs</value> </property>

Vytvořte adresář specifikovaný ve výše uvedeném nastavení-

sudo mkdir -p <Path of Directory used in above setting>

sudo mkdir -p /home/hduser_/hdfs

sudo chown -R hduser_:hadoop_ <Path of Directory created in above step>

sudo chown -R hduser_:hadoop_ /home/hduser_/hdfs

sudo chmod 750 <Path of Directory created in above step>

sudo chmod 750 /home/hduser_/hdfs

Krok 4) Než poprvé spustíme Hadoop, naformátujte HDFS pomocí níže uvedeného příkazu

$HADOOP_HOME/bin/hdfs namenode -format

Krok 5) Spusťte cluster s jedním uzlem Hadoop pomocí níže uvedeného příkazu

$HADOOP_HOME/sbin/start-dfs.sh

Výstup výše uvedeného příkazu

$HADOOP_HOME/sbin/start-yarn.sh

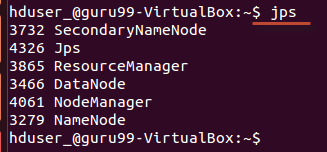

Použití 'jps' nástroj/příkaz, ověřte, zda všechny procesy související s Hadoopem běží nebo ne.

Pokud se Hadoop úspěšně spustil, měl by výstup jps zobrazovat NameNode, NodeManager, ResourceManager, SecondaryNameNode, DataNode.

Krok 6) Zastavení Hadoopu

$HADOOP_HOME/sbin/stop-dfs.sh

$HADOOP_HOME/sbin/stop-yarn.sh