Kuidas installida Hadoopi samm-sammult konfiguratsiooniga Linuxis Ubuntu

Selles õpetuses juhendame teid samm-sammult Apache Hadoopi installimiseks Linuxi kasti (Ubuntu). See on 2 osaline protsess

On 2 Eeldused

- Sul peab olema Ubuntu paigaldatud ja jooksmine

- Sul peab olema Java Paigaldatud.

Osa 1) Laadige alla ja installige Hadoop

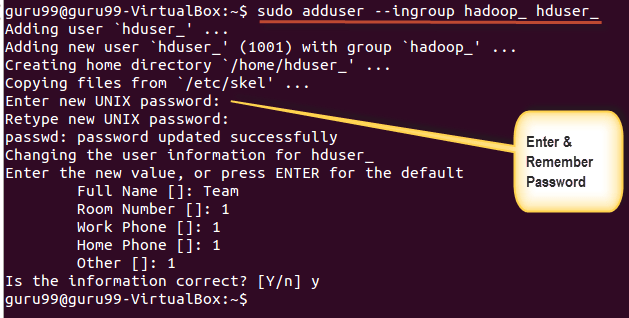

Step 1) Lisage Hadoopi süsteemi kasutaja, kasutades allolevat käsku

sudo addgroup hadoop_

sudo adduser --ingroup hadoop_ hduser_

Sisestage oma parool, nimi ja muud andmed.

MÄRKUS: Selles seadistus- ja installiprotsessis võib tekkida allpool nimetatud tõrge.

"hduser ei ole sudoersi failis. Sellest juhtumist teatatakse."

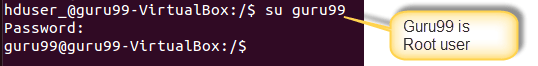

Selle vea saab lahendada juurkasutajana sisse logides

Käivitage käsk

sudo adduser hduser_ sudo

Re-login as hduser_

Step 2) Seadistage SSH

Klastris olevate sõlmede haldamiseks vajab Hadoop juurdepääsu SSH-le

Esmalt vahetage kasutajat ja sisestage järgmine käsk

su - hduser_

See käsk loob uue võtme.

ssh-keygen -t rsa -P ""

Lubage selle klahvi abil SSH-juurdepääs kohalikule masinale.

cat $HOME/.ssh/id_rsa.pub >> $HOME/.ssh/authorized_keys

Nüüd testige SSH seadistust, luues ühenduse kohaliku hostiga kui "hduser" kasutaja.

ssh localhost

Märge: Pange tähele, et kui näete allpool tõrketeadet vastuseks 'ssh localhostile', siis on võimalik, et SSH pole selles süsteemis saadaval.

Selle lahendamiseks –

Puhastage SSH, kasutades

sudo apt-get purge openssh-server

Hea tava on puhastada enne paigaldamise algust

Installige SSH, kasutades käsku-

sudo apt-get install openssh-server

Step 3) Järgmine samm on Laadige alla Hadoop

Valige Stabiilne

Valige fail tar.gz (mitte src-ga fail)

Kui allalaadimine on lõppenud, liikuge tar-faili sisaldavasse kataloogi

sisesta,

sudo tar xzf hadoop-2.2.0.tar.gz

Nüüd nimetage hadoop-2.2.0 ümber hadoopiks

sudo mv hadoop-2.2.0 hadoop

sudo chown -R hduser_:hadoop_ hadoop

2. osa) Hadoopi konfigureerimine

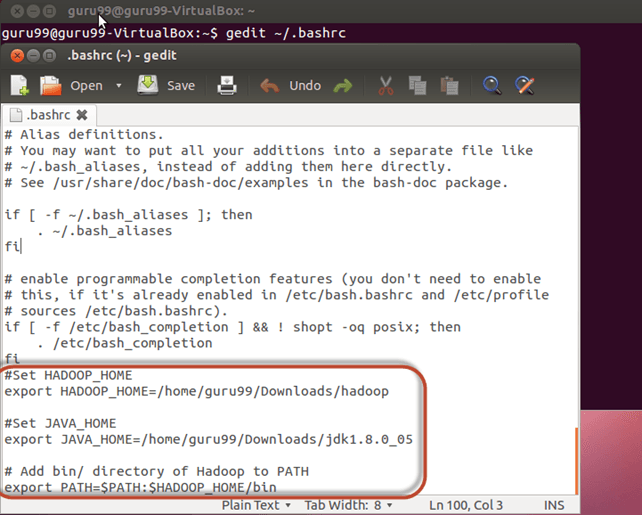

Step 1) muutma ~ / .bashrc fail

Lisage faili lõppu järgmised read ~ / .bashrc

#Set HADOOP_HOME export HADOOP_HOME=<Installation Directory of Hadoop> #Set JAVA_HOME export JAVA_HOME=<Installation Directory of Java> # Add bin/ directory of Hadoop to PATH export PATH=$PATH:$HADOOP_HOME/bin

Nüüd hankige see keskkonna konfiguratsioon alloleva käsu abil

. ~/.bashrc

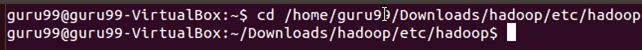

Step 2) HDFS-iga seotud konfiguratsioonid

komplekt JAVA_HOME faili sees $HADOOP_HOME/etc/hadoop/hadoop-env.sh

koos

Sees on kaks parameetrit $HADOOP_HOME/etc/hadoop/core-site.xml mis tuleb seadistada -

1. „hadoop.tmp.dir” – Kasutatakse kataloogi määramiseks, mida Hadoop kasutab oma andmefailide salvestamiseks.

2. 'fs.default.name' – See määrab vaikefailisüsteemi.

Nende parameetrite määramiseks avage core-site.xml

sudo gedit $HADOOP_HOME/etc/hadoop/core-site.xml

Kopeerige allpool rida siltide vahele

<property> <name>hadoop.tmp.dir</name> <value>/app/hadoop/tmp</value> <description>Parent directory for other temporary directories.</description> </property> <property> <name>fs.defaultFS </name> <value>hdfs://localhost:54310</value> <description>The name of the default file system. </description> </property>

Liikuge kataloogi $HADOOP_HOME/etc/Hadoop

Nüüd looge failis core-site.xml mainitud kataloog

sudo mkdir -p <Path of Directory used in above setting>

Andke kataloogile õigused

sudo chown -R hduser_:Hadoop_ <Path of Directory created in above step>

sudo chmod 750 <Path of Directory created in above step>

Step 3) Kaardi konfiguratsiooni vähendamine

Enne nende konfiguratsioonidega alustamist määrake HADOOP_HOME tee

sudo gedit /etc/profile.d/hadoop.sh

Ja Sisestage

export HADOOP_HOME=/home/guru99/Downloads/Hadoop

Järgmisena sisestage

sudo chmod +x /etc/profile.d/hadoop.sh

Väljuge terminalist ja taaskäivitage uuesti

Tippige echo $HADOOP_HOME. Tee kontrollimiseks

Nüüd kopeerige failid

sudo cp $HADOOP_HOME/etc/hadoop/mapred-site.xml.template $HADOOP_HOME/etc/hadoop/mapred-site.xml

avage mapred-site.xml fail

sudo gedit $HADOOP_HOME/etc/hadoop/mapred-site.xml

Lisage märgendite vahele allpool seadistusread ja

<property> <name>mapreduce.jobtracker.address</name> <value>localhost:54311</value> <description>MapReduce job tracker runs at this host and port. </description> </property>

avatud $HADOOP_HOME/etc/hadoop/hdfs-site.xml nagu allpool,

sudo gedit $HADOOP_HOME/etc/hadoop/hdfs-site.xml

Lisage märgendite vahele allpool seadistusread ja

<property> <name>dfs.replication</name> <value>1</value> <description>Default block replication.</description> </property> <property> <name>dfs.datanode.data.dir</name> <value>/home/hduser_/hdfs</value> </property>

Looge ülaltoodud seadistuses määratud kataloog -

sudo mkdir -p <Path of Directory used in above setting>

sudo mkdir -p /home/hduser_/hdfs

sudo chown -R hduser_:hadoop_ <Path of Directory created in above step>

sudo chown -R hduser_:hadoop_ /home/hduser_/hdfs

sudo chmod 750 <Path of Directory created in above step>

sudo chmod 750 /home/hduser_/hdfs

Step 4) Enne Hadoopi esmakordset käivitamist vormindage HDFS alloleva käsu abil

$HADOOP_HOME/bin/hdfs namenode -format

Step 5) Käivitage Hadoopi ühe sõlme klaster, kasutades allolevat käsku

$HADOOP_HOME/sbin/start-dfs.sh

Ülaltoodud käsu väljund

$HADOOP_HOME/sbin/start-yarn.sh

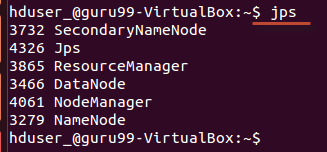

Kasutamine 'jps' tööriist/käsk, kontrollige, kas kõik Hadoopiga seotud protsessid töötavad või mitte.

Kui Hadoop on edukalt käivitunud, peaks jps-i väljund näitama NameNode, NodeManager, ResourceManager, SecondaryNameNode, DataNode.

Step 6) Hadoopi peatamine

$HADOOP_HOME/sbin/stop-dfs.sh

$HADOOP_HOME/sbin/stop-yarn.sh