Hur man installerar Hadoop med steg-för-steg-konfiguration på Linux Ubuntu

I den här handledningen tar vi dig genom steg för steg-processen för att installera Apache Hadoop på en Linux-box (Ubuntu). Detta är en process i två delar

Det finns 2 Förutsättningar

- Du måste ha Ubuntu installerad och kör

- Du måste ha Java Installerad.

Del 1) Ladda ner och installera Hadoop

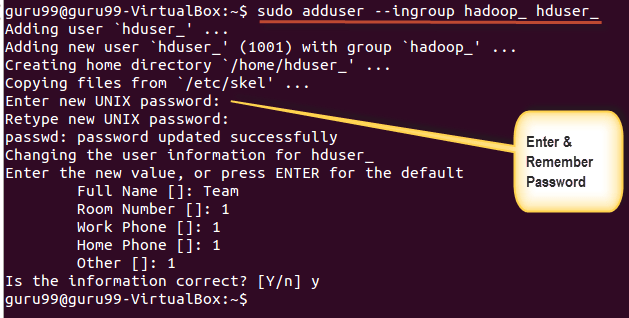

Steg 1) Lägg till en Hadoop-systemanvändare med kommandot nedan

sudo addgroup hadoop_

sudo adduser --ingroup hadoop_ hduser_

Ange ditt lösenord, namn och andra detaljer.

OBS: Det finns en möjlighet för nedan nämnda fel i den här installations- och installationsprocessen.

"hduser finns inte i sudoers-filen. Denna händelse kommer att rapporteras.”

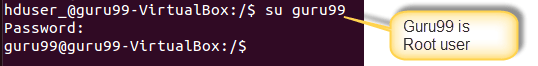

Detta fel kan lösas genom att logga in som root-användare

Kör kommandot

sudo adduser hduser_ sudo

Re-login as hduser_

Steg 2) Konfigurera SSH

För att hantera noder i ett kluster kräver Hadoop SSH-åtkomst

Byt användare först, skriv in följande kommando

su - hduser_

Detta kommando skapar en ny nyckel.

ssh-keygen -t rsa -P ""

Aktivera SSH-åtkomst till lokal maskin med denna nyckel.

cat $HOME/.ssh/id_rsa.pub >> $HOME/.ssh/authorized_keys

Testa nu SSH-inställningen genom att ansluta till localhost som 'hduser'-användare.

ssh localhost

Obs: Observera att om du ser felet nedan som svar på 'ssh localhost', så finns det en möjlighet att SSH inte är tillgängligt på detta system-

För att lösa detta –

Rensa SSH med,

sudo apt-get purge openssh-server

Det är bra att rensa innan installationen påbörjas

Installera SSH med kommandot-

sudo apt-get install openssh-server

Steg 3) Nästa steg är att Ladda ner Hadoop

Välj Stabil

Välj filen tar.gz (inte filen med src)

När en nedladdning är klar, navigera till katalogen som innehåller tar-filen

Enter,

sudo tar xzf hadoop-2.2.0.tar.gz

Byt nu namn på hadoop-2.2.0 till hadoop

sudo mv hadoop-2.2.0 hadoop

sudo chown -R hduser_:hadoop_ hadoop

Del 2) Konfigurera Hadoop

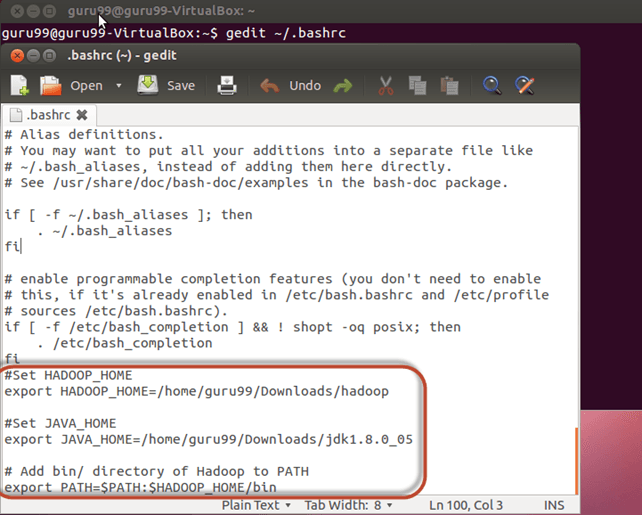

Steg 1) Ändra ~ / .bashrc fil

Lägg till följande rader i slutet av filen ~ / .bashrc

#Set HADOOP_HOME export HADOOP_HOME=<Installation Directory of Hadoop> #Set JAVA_HOME export JAVA_HOME=<Installation Directory of Java> # Add bin/ directory of Hadoop to PATH export PATH=$PATH:$HADOOP_HOME/bin

Käll nu in den här miljökonfigurationen med kommandot nedan

. ~/.bashrc

Steg 2) Konfigurationer relaterade till HDFS

uppsättning JAVA_HOME inuti filen $HADOOP_HOME/etc/hadoop/hadoop-env.sh

Med

Det finns två parametrar i $HADOOP_HOME/etc/hadoop/core-site.xml som måste ställas in-

1. 'hadoop.tmp.dir' – Används för att ange en katalog som ska användas av Hadoop för att lagra dess datafiler.

2. 'fs.default.name' – Detta anger standardfilsystemet.

För att ställa in dessa parametrar, öppna core-site.xml

sudo gedit $HADOOP_HOME/etc/hadoop/core-site.xml

Kopiera nedanstående rad mellan taggarna

<property> <name>hadoop.tmp.dir</name> <value>/app/hadoop/tmp</value> <description>Parent directory for other temporary directories.</description> </property> <property> <name>fs.defaultFS </name> <value>hdfs://localhost:54310</value> <description>The name of the default file system. </description> </property>

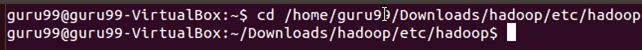

Navigera till katalogen $HADOOP_HOME/etc/Hadoop

Skapa nu katalogen som nämns i core-site.xml

sudo mkdir -p <Path of Directory used in above setting>

Ge behörigheter till katalogen

sudo chown -R hduser_:Hadoop_ <Path of Directory created in above step>

sudo chmod 750 <Path of Directory created in above step>

Steg 3) Map Reduce Configuration

Innan du börjar med dessa konfigurationer, låt oss ställa in HADOOP_HOME-sökvägen

sudo gedit /etc/profile.d/hadoop.sh

Och Enter

export HADOOP_HOME=/home/guru99/Downloads/Hadoop

Ange nästa

sudo chmod +x /etc/profile.d/hadoop.sh

Stäng terminalen och starta om igen

Skriv echo $HADOOP_HOME. För att verifiera sökvägen

Kopiera nu filer

sudo cp $HADOOP_HOME/etc/hadoop/mapred-site.xml.template $HADOOP_HOME/etc/hadoop/mapred-site.xml

Öppna mapred-site.xml fil

sudo gedit $HADOOP_HOME/etc/hadoop/mapred-site.xml

Lägg till nedanstående rader med inställning mellan taggar och

<property> <name>mapreduce.jobtracker.address</name> <value>localhost:54311</value> <description>MapReduce job tracker runs at this host and port. </description> </property>

Öppet $HADOOP_HOME/etc/hadoop/hdfs-site.xml som nedan,

sudo gedit $HADOOP_HOME/etc/hadoop/hdfs-site.xml

Lägg till nedanstående inställningsrader mellan taggar och

<property> <name>dfs.replication</name> <value>1</value> <description>Default block replication.</description> </property> <property> <name>dfs.datanode.data.dir</name> <value>/home/hduser_/hdfs</value> </property>

Skapa en katalog specificerad i ovanstående inställning-

sudo mkdir -p <Path of Directory used in above setting>

sudo mkdir -p /home/hduser_/hdfs

sudo chown -R hduser_:hadoop_ <Path of Directory created in above step>

sudo chown -R hduser_:hadoop_ /home/hduser_/hdfs

sudo chmod 750 <Path of Directory created in above step>

sudo chmod 750 /home/hduser_/hdfs

Steg 4) Innan vi startar Hadoop för första gången, formatera HDFS med kommandot nedan

$HADOOP_HOME/bin/hdfs namenode -format

Steg 5) Starta Hadoop enkelnodkluster med kommandot nedan

$HADOOP_HOME/sbin/start-dfs.sh

En utdata av ovanstående kommando

$HADOOP_HOME/sbin/start-yarn.sh

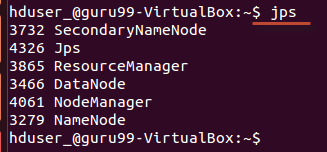

Använda 'jps' verktyg/kommando, verifiera om alla Hadoop-relaterade processer körs eller inte.

Om Hadoop har startat framgångsrikt bör en utdata av jps visa NameNode, NodeManager, ResourceManager, SecondaryNameNode, DataNode.

Steg 6) Stoppar Hadoop

$HADOOP_HOME/sbin/stop-dfs.sh

$HADOOP_HOME/sbin/stop-yarn.sh