NLTK 토큰화: 예제가 포함된 단어 및 문장 토크나이저

토큰 화란 무엇입니까?

토큰 화 대량의 텍스트를 토큰이라는 작은 부분으로 나누는 프로세스입니다. 이러한 토큰은 패턴을 찾는 데 매우 유용하며 형태소 분석 및 표제어 추출을 위한 기본 단계로 간주됩니다. 토큰화는 민감한 데이터 요소를 민감하지 않은 데이터 요소로 대체하는 데도 도움이 됩니다.

자연어 처리는 텍스트 분류와 같은 애플리케이션 구축에 사용됩니다. 지능형 챗봇, 감성 분석, 언어 번역 등 위에서 언급한 목적을 달성하려면 텍스트의 패턴을 이해하는 것이 중요합니다.

당장은 어간 추출과 레마티제이션에 대해 걱정하지 말고 NLP(자연어 처리)를 사용한 텍스트 데이터 정리 단계로 취급하세요. 튜토리얼 후반부에서 어간 추출과 레마티제이션에 대해 논의하겠습니다. 다음과 같은 작업 텍스트 분류 또는 스팸 필터링 Keras와 같은 딥러닝 라이브러리와 함께 NLP를 사용합니다. 텐서 플로우.

자연어 툴킷에는 매우 중요한 모듈 NLTK가 있습니다. 토큰 화하다 하위 모듈로 더 구성되는 문장

- 단어 토큰화

- 문장 토큰화

단어의 토큰화

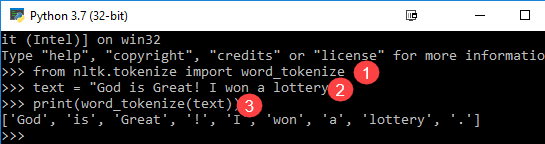

우리는 방법을 사용합니다 단어_토큰화() 문장을 단어로 나누는 것. 기계 학습 애플리케이션에서 더 나은 텍스트 이해를 위해 단어 토큰화의 출력을 데이터 프레임으로 변환할 수 있습니다. 또한 구두점 제거, 숫자 제거 또는 형태소 분석과 같은 추가 텍스트 정리 단계를 위한 입력으로 제공될 수도 있습니다. 기계 학습 모델을 훈련하고 예측하려면 숫자 데이터가 필요합니다. 단어 토큰화는 텍스트(문자열)를 숫자 데이터로 변환하는 데 중요한 부분이 됩니다. 다음 내용을 읽어보세요. Bag of Words 또는 CountVectorizer. 이론을 더 잘 이해하려면 아래 단어 토큰화 NLTK 예를 참조하세요.

from nltk.tokenize import word_tokenize text = "God is Great! I won a lottery." print(word_tokenize(text)) Output: ['God', 'is', 'Great', '!', 'I', 'won', 'a', 'lottery', '.']

코드 설명

- word_tokenize 모듈은 NLTK 라이브러리에서 가져옵니다.

- 변수 "text"는 두 문장으로 초기화됩니다.

- text 변수는 word_tokenize 모듈에 전달되어 결과를 인쇄합니다. 이 모듈은 출력에서 볼 수 있는 구두점으로 각 단어를 구분합니다.

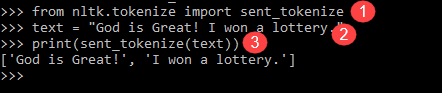

문장의 토큰화

위에서 사용할 수 있는 하위 모듈은 sent_tokenize입니다. 당신의 마음 속에 분명한 질문은 다음과 같습니다 단어 토큰화 옵션이 있는데 문장 토큰화가 필요한 이유. 문장당 평균 단어 수를 계산해야 한다고 상상해 보세요. 어떻게 계산합니까? 이러한 작업을 수행하려면 비율을 계산하기 위해 NLTK 문장 토크나이저와 NLTK 단어 토크나이저가 모두 필요합니다. 이러한 출력은 대답이 숫자이기 때문에 기계 학습의 중요한 기능으로 사용됩니다.

문장 토큰화가 단어 토큰화와 어떻게 다른지 알아보려면 아래 NLTK 토크나이저 예제를 확인하세요.

from nltk.tokenize import sent_tokenize text = "God is Great! I won a lottery." print(sent_tokenize(text)) Output: ['God is Great!', 'I won a lottery ']

우리는이 12 단어와 두 문장 동일한 입력에 대해.

프로그램 설명

- 이전 프로그램과 같은 줄에서 sent_tokenize 모듈을 가져왔습니다.

- 우리는 같은 문장을 취했습니다. NLTK 모듈의 추가 문장 토크나이저는 해당 문장을 구문 분석하고 출력을 표시합니다. 이 기능이 각 문장을 깨뜨리는 것은 분명합니다.

위의 단어 토크나이저 Python 예는 단어와 문장 토큰화의 메커니즘을 이해하는 데 좋은 설정 돌입니다.

제품 개요

- 토큰화 NLP 대량의 텍스트를 토큰이라는 작은 부분으로 나누는 프로세스입니다.

- 자연어 처리는 텍스트 분류, 지능형 챗봇, 감정 분석, 언어 번역 등과 같은 애플리케이션을 구축하는 데 사용됩니다.

- 자연어 툴킷에는 하위 모듈로 구성된 매우 중요한 NLTK 문장 토큰화 모듈이 있습니다.

- 문장을 단어로 분할하려면 word_tokenize() 메서드를 사용합니다. 기계 학습 애플리케이션에서 더 나은 텍스트 이해를 위해 NLTK의 단어 토크나이저 출력을 데이터 프레임으로 변환할 수 있습니다.

- 위에서 사용할 수 있는 하위 모듈은 sent_tokenize입니다. 문장 토크나이저 Python NLTK는 기계 학습에 중요한 기능입니다.