Linux 上でステップバイステップ構成で Hadoop をインストールする方法 Ubuntu

このチュートリアルでは、LinuxボックスにApache Hadoopをインストールする手順を段階的に説明します(Ubuntu)。これは 2 つの部分からなるプロセスです

2あり 前提条件

- あなたが持っている必要があります Ubuntu インストール そして実行中

- あなたが持っている必要があります Java インストールされています。

パート 1) Hadoop をダウンロードしてインストールする

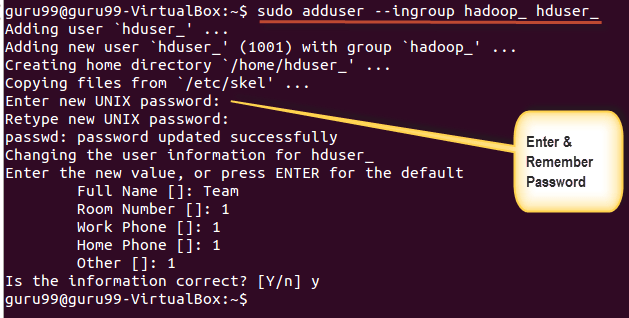

ステップ1) 以下のコマンドを使用して Hadoop システム ユーザーを追加します

sudo addgroup hadoop_

sudo adduser --ingroup hadoop_ hduser_

パスワード、名前、その他の詳細を入力します。

注: このセットアップおよびインストール処理において、以下のようなエラーが発生する可能性があります。

「hduser は sudoers ファイルにありません。 この事件は報道されます。」

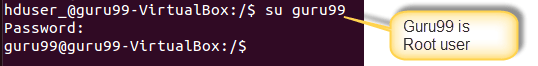

このエラーは、root ユーザーとしてログインすることで解決できます。

コマンドを実行する

sudo adduser hduser_ sudo

Re-login as hduser_

ステップ2) SSH の構成

クラスタ内のノードを管理するには、HadoopはSSHアクセスを必要とする。

まず、ユーザーを切り替えて、次のコマンドを入力します

su - hduser_

このコマンドは新しいキーを作成します。

ssh-keygen -t rsa -P ""

このキーを使用してローカル マシンへの SSH アクセスを有効にします。

cat $HOME/.ssh/id_rsa.pub >> $HOME/.ssh/authorized_keys

次に、「hduser」ユーザーとしてローカルホストに接続して、SSH セットアップをテストします。

ssh localhost

注意: 「ssh localhost」への応答で以下のエラーが表示された場合は、このシステムで SSH が利用できない可能性があることに注意してください。

これを解決するには –

を使用して SSH をパージします。

sudo apt-get purge openssh-server

インストールを開始する前にパージすることをお勧めします

コマンドを使用して SSH をインストールします。

sudo apt-get install openssh-server

ステップ3) 次のステップは、 Hadoopをダウンロード

安定を選択

tar.gz ファイルを選択します (src を含むファイルではありません)。

ダウンロードが完了したら、tar ファイルが含まれるディレクトリに移動します。

を入力し、

sudo tar xzf hadoop-2.2.0.tar.gz

ここで、hadoop-2.2.0 の名前を hadoop に変更します。

sudo mv hadoop-2.2.0 hadoop

sudo chown -R hduser_:hadoop_ hadoop

パート 2) Hadoop の構成

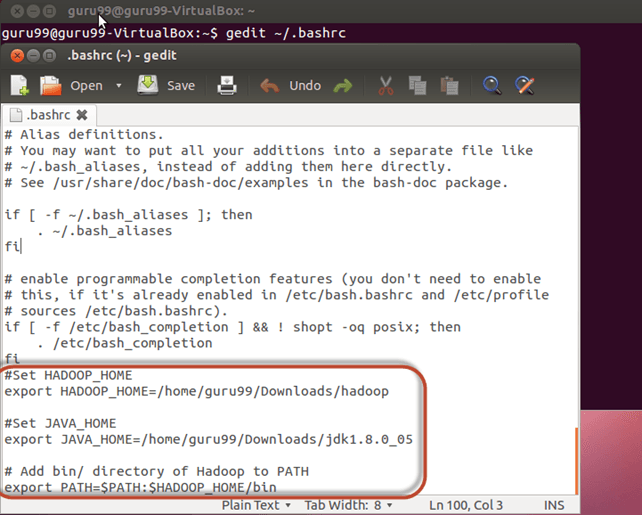

ステップ1) 修正します 〜/ .bashrc file

ファイルの末尾に次の行を追加します 〜/ .bashrc

#Set HADOOP_HOME export HADOOP_HOME=<Installation Directory of Hadoop> #Set JAVA_HOME export JAVA_HOME=<Installation Directory of Java> # Add bin/ directory of Hadoop to PATH export PATH=$PATH:$HADOOP_HOME/bin

次に、以下のコマンドを使用してこの環境構成を取得します。

. ~/.bashrc

ステップ2) HDFS に関連する構成

作成セッションプロセスで JAVA_HOME ファイル内 $HADOOP_HOME/etc/hadoop/hadoop-env.sh

自律的AI

パラメータは XNUMX つあります $HADOOP_HOME/etc/hadoop/core-site.xml どれを設定する必要がありますか-

1. 「hadoop.tmp.dir」 – Hadoop がデータ ファイルを保存するために使用するディレクトリを指定するために使用されます。

2.「fs.default.name」 – これにより、デフォルトのファイル システムが指定されます。

これらのパラメータを設定するには、core-site.xml を開きます。

sudo gedit $HADOOP_HOME/etc/hadoop/core-site.xml

タグ間の以下の行をコピーします

<property> <name>hadoop.tmp.dir</name> <value>/app/hadoop/tmp</value> <description>Parent directory for other temporary directories.</description> </property> <property> <name>fs.defaultFS </name> <value>hdfs://localhost:54310</value> <description>The name of the default file system. </description> </property>

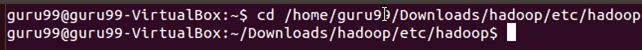

ディレクトリに移動します $HADOOP_HOME/etc/Hadoop

ここで、core-site.xml に記載されているディレクトリを作成します。

sudo mkdir -p <Path of Directory used in above setting>

ディレクトリにアクセス許可を付与します

sudo chown -R hduser_:Hadoop_ <Path of Directory created in above step>

sudo chmod 750 <Path of Directory created in above step>

ステップ3) マップリデュース構成

これらの構成を始める前に、HADOOP_HOME パスを設定しましょう

sudo gedit /etc/profile.d/hadoop.sh

そして入力してください

export HADOOP_HOME=/home/guru99/Downloads/Hadoop

次の入力

sudo chmod +x /etc/profile.d/hadoop.sh

ターミナルを終了し、再度起動します

「echo $HADOOP_HOME」と入力します。 パスを確認するには

ファイルをコピーします

sudo cp $HADOOP_HOME/etc/hadoop/mapred-site.xml.template $HADOOP_HOME/etc/hadoop/mapred-site.xml

Video Cloud Studioで マップレッドサイト.xml file

sudo gedit $HADOOP_HOME/etc/hadoop/mapred-site.xml

タグの間に以下の設定行を追加しますそして

<property> <name>mapreduce.jobtracker.address</name> <value>localhost:54311</value> <description>MapReduce job tracker runs at this host and port. </description> </property>

店は開いています $HADOOP_HOME/etc/hadoop/hdfs-site.xml 以下のように、

sudo gedit $HADOOP_HOME/etc/hadoop/hdfs-site.xml

タグの間に以下の設定行を追加しますそして

<property> <name>dfs.replication</name> <value>1</value> <description>Default block replication.</description> </property> <property> <name>dfs.datanode.data.dir</name> <value>/home/hduser_/hdfs</value> </property>

上記の設定で指定したディレクトリを作成します-

sudo mkdir -p <Path of Directory used in above setting>

sudo mkdir -p /home/hduser_/hdfs

sudo chown -R hduser_:hadoop_ <Path of Directory created in above step>

sudo chown -R hduser_:hadoop_ /home/hduser_/hdfs

sudo chmod 750 <Path of Directory created in above step>

sudo chmod 750 /home/hduser_/hdfs

ステップ4) 初めて Hadoop を起動する前に、以下のコマンドを使用して HDFS をフォーマットします。

$HADOOP_HOME/bin/hdfs namenode -format

ステップ5) 以下のコマンドを使用してHadoopシングルノードクラスタを起動します。

$HADOOP_HOME/sbin/start-dfs.sh

上記のコマンドの出力

$HADOOP_HOME/sbin/start-yarn.sh

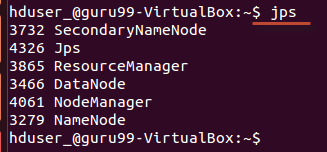

使い方 「jps」 ツール/コマンドを使用して、すべての Hadoop 関連プロセスが実行されているかどうかを確認します。

Hadoop が正常に開始された場合、jps の出力には NameNode、NodeManager、ResourceManager、SecondaryNameNode、DataNode が表示されるはずです。

ステップ6) Hadoopの停止

$HADOOP_HOME/sbin/stop-dfs.sh

$HADOOP_HOME/sbin/stop-yarn.sh